Table of Contents

Avanços em IA Open-Source: Lançamento do Llama 3.2 pela Meta

Recentemente, a área de Inteligência Artificial (IA) open-source vivenciou um marco significativo com o anúncio da Meta sobre a atualização de seu modelo de linguagem, o Llama 3.2. Este novo modelo não se limita a processar texto; agora, ele também possui capacidades visuais, o que representa uma evolução crucial para aplicações de IA em dispositivos móveis e interações locais.

Características Distintas do Llama 3.2

O Llama 3.2 apresenta-se em quatro variantes, diferenciadas por suas capacidades de processamento:

- Modelos 11B e 90B: Focados em aplicações robustas, capazes de processar tanto textos quanto imagens com alta eficiência.

- Modelos 1B e 3B: Projetados para tarefas menos exigentes em termos de computação, mas com a habilidade de integrar-se melhor a ferramentas de programação.

Esses modelos permitem a realização de tarefas complexas, como análise de gráficos e identificação de objetos em imagens a partir de descrições em linguagem natural.

Desempenho Comparativo e Avanços Técnicos

O lançamento do Llama 3.2 coincide com o anúncio do Molmo, um novo modelo multimodal do Allen Institute que promete rivalizar com gigantes da tecnologia. Durante os testes, o Llama 3.2 demonstrou desempenho competitivo, superando modelos como o Gemma 2 e o Phi-2 em diversas métricas.

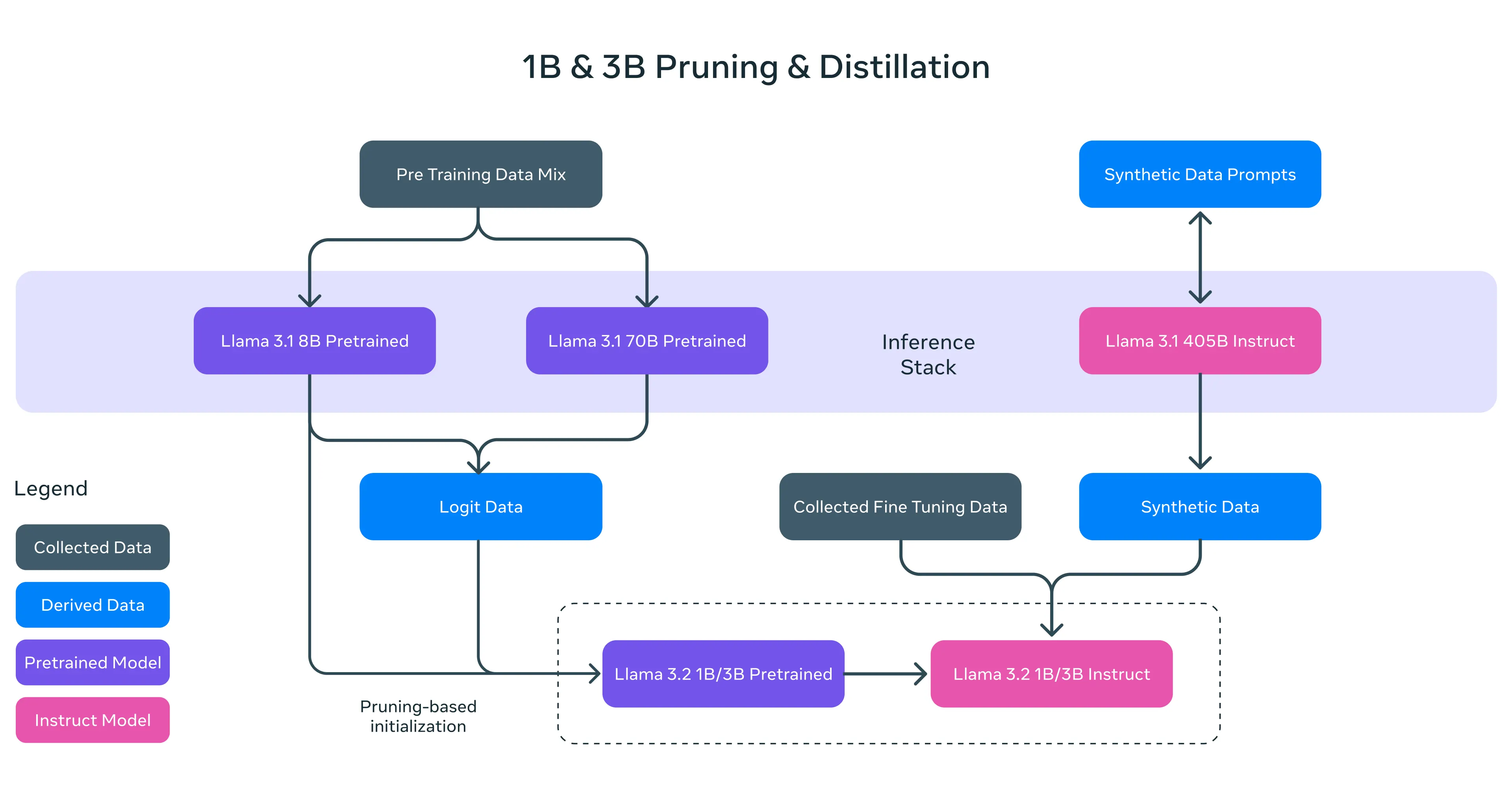

A equipe de engenharia da Meta utilizou técnicas como pruning estruturado e distilação de conhecimento para reduzir a complexidade do modelo, gerando um conjunto de modelos compactos e eficientes que mantêm a qualidade do processamento.

Compatibilidade e Integração com Dispositivos

A Meta está ativamente colaborando com líderes de hardware como Qualcomm e MediaTek, garantindo que o Llama 3.2 opere de forma eficiente em dispositivos móveis. Além disso, a integração com plataformas de computação em nuvem como AWS, Google Cloud e Microsoft Azure promete facilitar o acesso e a execução do modelo em aplicações variadas.

Testes Práticos e Desempenho do Modelo

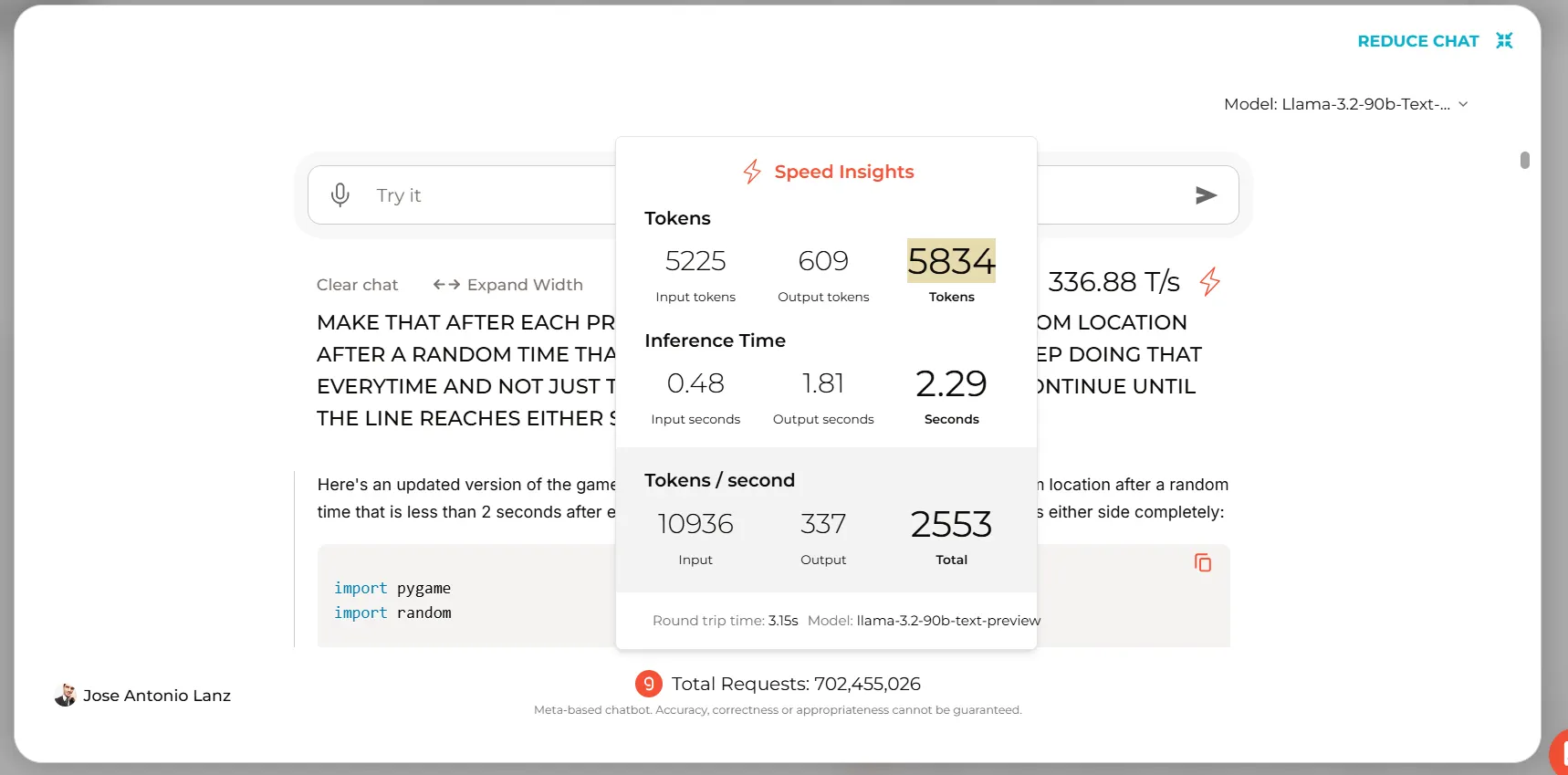

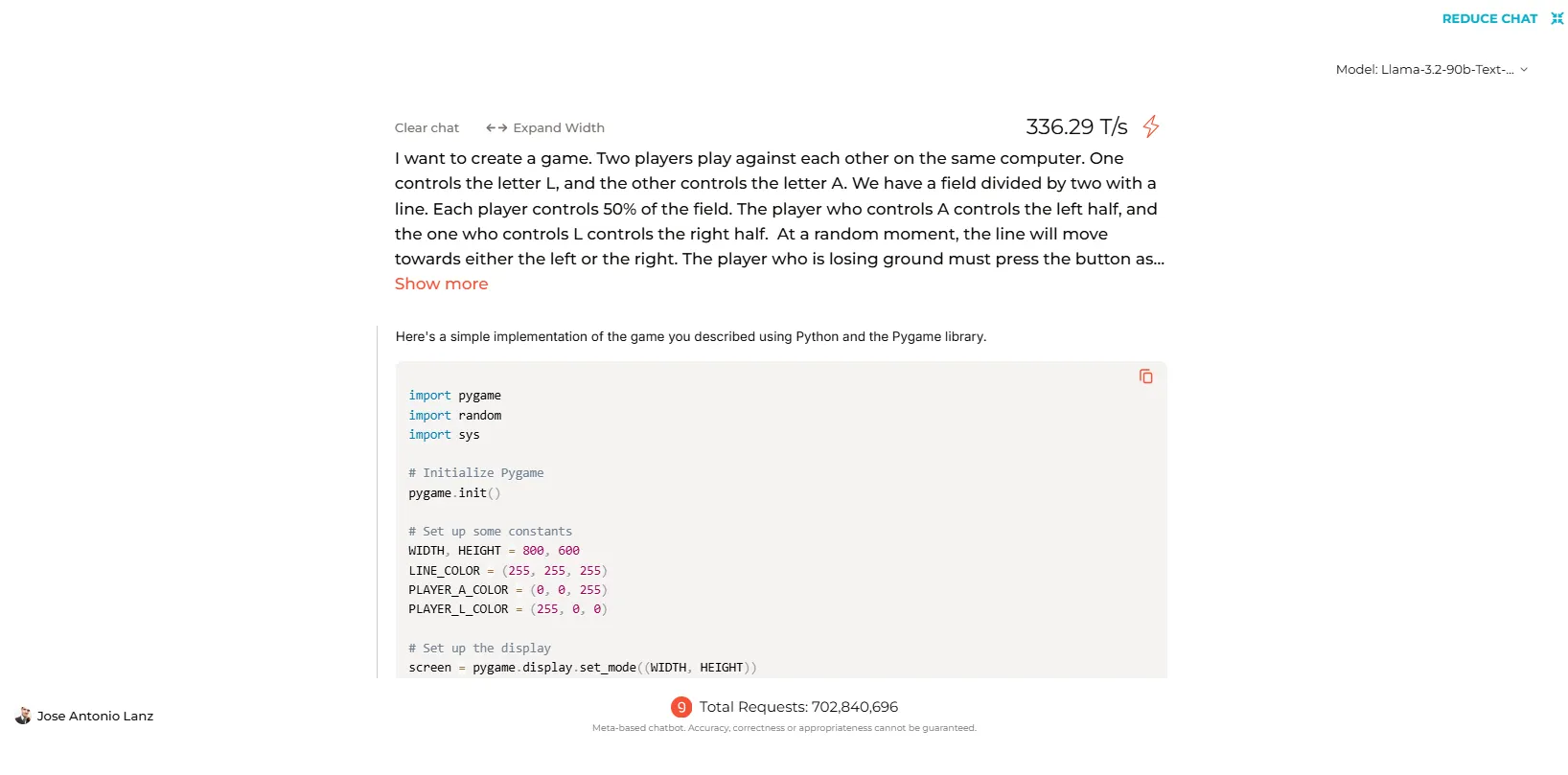

Nos testes realizados, o Llama 3.2 manteve um desempenho igual ao de suas versões anteriores em interações baseadas em texto, mas apresentou resultados mistos na geração de código. A versão de 90 bilhões de parâmetros se destacou ao criar um jogo funcional em um único teste, mostrando a sua robustez em tarefas de programação complexas.

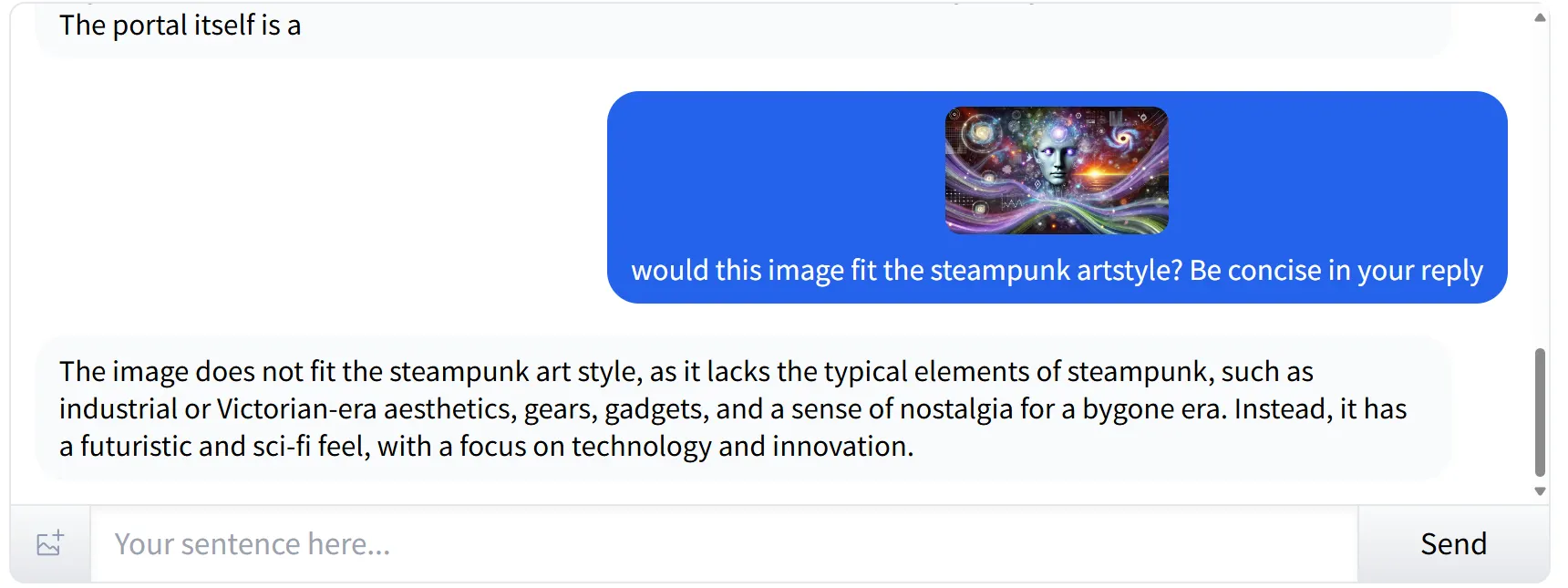

Análise e Interpretação de Imagens

Uma das habilidades notáveis do Llama 3.2 é sua capacidade de reconhecer elementos subjetivos em imagens, como demonstrado em um teste onde o modelo analisou uma imagem no estilo cyberpunk, fornecendo uma descrição adequada sobre seu alinhamento com outros estilos, como o steampunk.

Identificação de Texto e Análise de Gráficos

Ainda que o Llama 3.2 tenha demonstrado dificuldades em analisar gráficos de baixa resolução, ele se destacou na leitura de textos em imagens de maior qualidade, reconhecendo contextos e distinções de maneira eficaz.

Considerações Finais

Em suma, o Llama 3.2 representa um avanço significativo em relação à sua geração anterior, destacando-se no campo da interpretação de imagens e no reconhecimento de texto em grande escala. No entanto, há áreas que ainda requerem melhorias, especialmente em relação à análise de imagens de baixa qualidade e à criação de códigos complexos. A promessa de compatibilidade em dispositivos móveis é um indicativo positivo para o futuro das interações de IA privadas e locais.

#AvançosEmIA

#Llama3.2

#IntelignciaArtificial

#ModelosDeLinguagem

#DispositivosMóveis

autor original: Jose Antonio Lanz

ref:https://decrypt.co/283308/meta-unveils-open-source-llama-ai-fits-in-your-pocket