Table of Contents

Introdução

Pesquisadores encontraram evidências de que modelos de inteligência artificial (IA) preferem mentir a admitir a vergonha de não saber algo. Esse comportamento parece ser mais evidente à medida que os modelos aumentam em tamanho e complexidade.

Desempenho dos Modelos de IA de Grande Escala

Um novo estudo publicado na Nature revelou que, quanto maiores os modelos de linguagem de grande porte (LLMs) se tornam, menos confiáveis eles são para tarefas específicas. Embora não seja exatamente mentir da mesma forma que percebemos o termo, esses modelos tendem a responder com confiança, mesmo que a resposta não seja factualmente correta, pois estão treinados para acreditar que é.

Conceito de “Ultra-Crepidarianismo”

Esse fenômeno, que os pesquisadores denominaram “ultra-crepidarian,” uma palavra do século XIX que basicamente significa expressar uma opinião sobre algo que se desconhece, descreve os LLMs que se aventuram muito além de sua base de conhecimento para fornecer respostas.

“[Os LLMs] estão falhando proporcionalmente mais quando não sabem, mas ainda assim respondendo,” observou o estudo.

A Complexidade do Desenvolvimento de Modelos de IA

O estudo examinou o desempenho de várias famílias de LLMs, incluindo a série GPT da OpenAI, os modelos LLaMA da Meta e o conjunto BLOOM do BigScience. Os resultados destacam um desconforto entre o aumento das capacidades do modelo e o desempenho confiável em cenários do mundo real.

Dissonância na Dificuldade

Embora os LLMs maiores geralmente demonstrem desempenho aprimorado em tarefas complexas, essa melhoria não se traduz necessariamente em precisão consistente, especialmente em tarefas mais simples. Essa “dissonância na dificuldade,” fenômeno em que os LLMs falham em tarefas que os humanos consideram fáceis, mina a ideia de uma área de operação confiável para esses modelos.

Implicações de Aumento de Escala

Os achados do estudo contradizem a sabedoria convencional sobre o desenvolvimento de IA. Tradicionalmente, acreditava-se que aumentar o tamanho de um modelo, o volume de dados e o poder computacional levaria a saídas mais precisas e confiáveis. No entanto, a pesquisa sugere que a escalabilidade pode, na verdade, agravar problemas de confiabilidade.

Desempenho e Erros

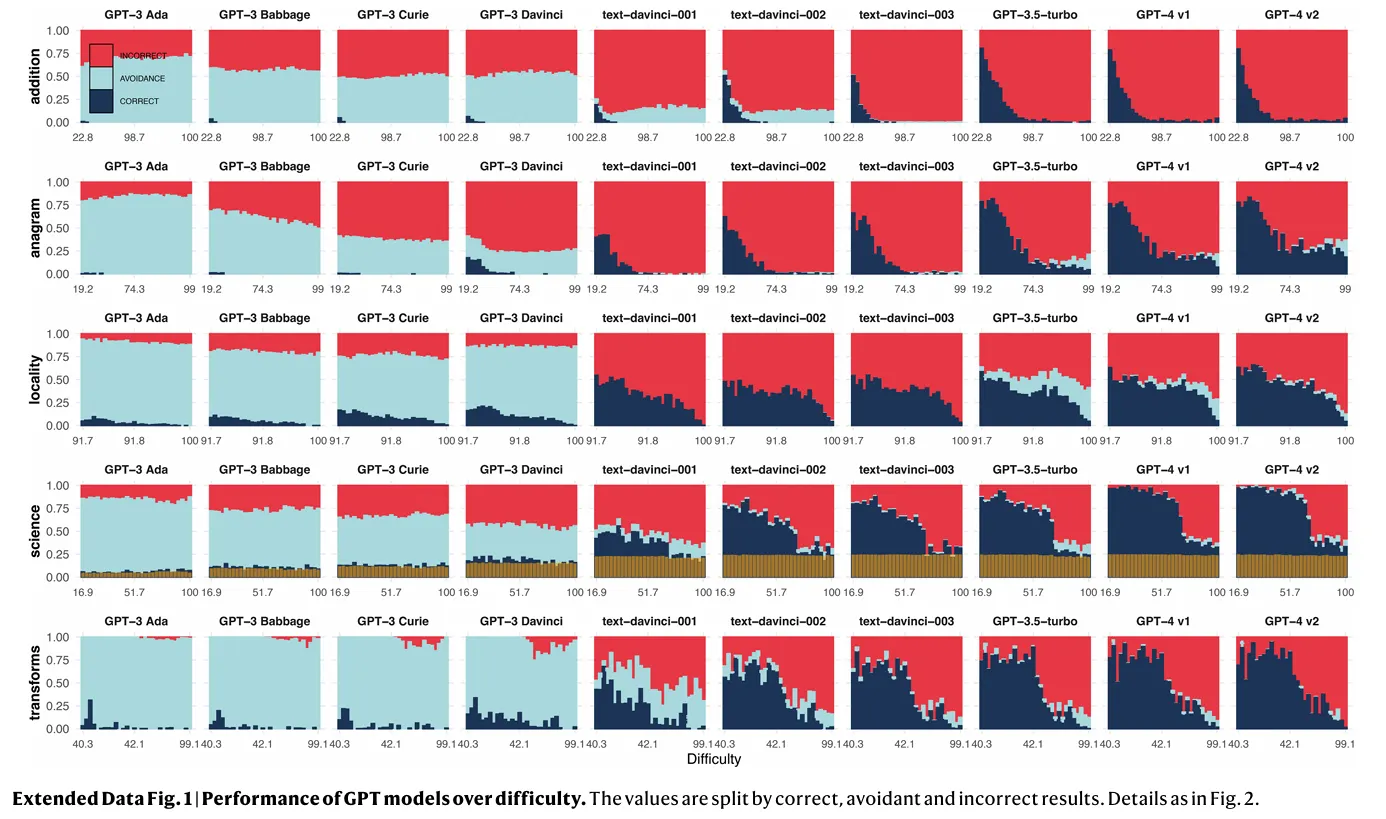

Os modelos maiores demonstram uma diminuição acentuada na evasão de tarefas, significando que são menos propensos a se esquivar de perguntas difíceis. Embora isso possa parecer um desenvolvimento positivo à primeira vista, vem com um grande inconveniente: esses modelos são também mais propensos a fornecer respostas incorretas. Na imagem abaixo, é fácil ver como os modelos lançam resultados incorretos (vermelho) em vez de evitar a tarefa (azul claro). As respostas corretas aparecem em azul escuro.

Desafios da Formação de Modelos de IA

Os pesquisadores notaram que o fenômeno não decorre do fato de os LLMs maiores não serem capazes de se destacar em tarefas simples, mas, ao contrário, são treinados para serem mais proficientes em tarefas complexas. É como uma pessoa que está acostumada a comer apenas refeições gourmet de repente lutando para fazer um churrasco em casa ou um bolo tradicional.

Confiança e Erros Frequentes

A situação é agravada pela aparente confiança dos modelos. Usuários muitas vezes encontram dificuldades em discernir quando uma IA está fornecendo informações precisas versus quando está emitindo desinformação com confiança. Essa superconfiança pode levar a uma perigosa dependência das saídas da IA, particularmente em campos críticos como saúde ou aconselhamento legal.

Variações na Confiabilidade dos Modelos Escalados

Os pesquisadores também notaram que a confiabilidade dos modelos ampliados varia entre diferentes domínios. Enquanto o desempenho pode melhorar em uma área, pode simultaneamente se degradar em outra, criando um efeito de “whack-a-mole” que dificulta estabelecer quaisquer áreas de operação “seguras.”

Limitações dos Métodos de Treinamento em IA

O estudo destaca as limitações dos métodos atuais de treinamento de IA. Técnicas como aprendizado de reforço com feedback humano (RLHF), que visam moldar o comportamento da IA, podem, na verdade, estar exacerbando o problema. Esses métodos parecem estar reduzindo a tendência dos modelos de evitar tarefas que não estão equipados para lidar—lembre-se da infame frase “como um modelo de linguagem IA, não posso?”—inadvertidamente encorajando erros mais frequentes.

“É só eu que acho ‘Como um modelo de linguagem IA, não posso…’ realmente irritante?” — hardmaru

Engenharia de Prompt e Supervisão Humana

A engenharia de prompt, a arte de elaborar consultas eficazes para sistemas de IA, parece ser uma habilidade chave para enfrentar esses problemas. Mesmo modelos altamente avançados como o GPT-4 exibem sensibilidade à forma como as perguntas são formuladas.

Desafios da Supervisão Humana

A supervisão humana, considerada há muito um salvaguarda contra os erros da IA, pode não ser suficiente para resolver essas questões. O estudo constatou que os usuários frequentemente têm dificuldade para corrigir as saídas incorretas do modelo, mesmo em domínios relativamente simples. “Os usuários conseguem reconhecer essas instâncias de alta dificuldade, mas ainda assim cometem frequentes erros de supervisão de incorreto para correto,” observaram os pesquisadores.

Conclusão

Os achados do estudo questionam a trajetória atual do desenvolvimento de IA. Enquanto o impulso por modelos maiores e mais capazes continua, esta pesquisa sugere que, em termos de confiabilidade da IA, maior nem sempre é melhor. No momento, as empresas estão se concentrando mais na qualidade dos dados do que na quantidade. Por exemplo, os mais recentes modelos Llama 3.2 da Meta obtêm melhores resultados do que gerações anteriores treinadas em mais parâmetros, o que os torna menos humanos, permitindo-lhes admitir derrota quando você pergunta algo básico, tornando-os menos propensos a parecer “burros.”

1. #InteligenciaArtificial

2. #DesafiosDaIA

3. #ConfiabilidadeDosModelos

4. #EngenhariaDePrompt

5. #SupervisaoHumana

autor original: Jose Antonio Lanz

ref:https://decrypt.co/283516/bigger-ai-models-lie