Table of Contents

Tecnologia de Multiplicação de Complexidade Linear (L-Mul) e sua Relevância na Eficiência Energética dos Modelos de IA

A crescente preocupação com o consumo de energia pelos modelos de Inteligência Artificial (IA) tem motivado a pesquisa por técnicas que visem reduzir esse impacto. Uma nova abordagem, denominada Linear-Complexity Multiplication (L-Mul), promete reduzir o consumo de energia em até 95%, sem comprometer a qualidade dos resultados dos modelos.

O Desafio do Consumo Energético em IA

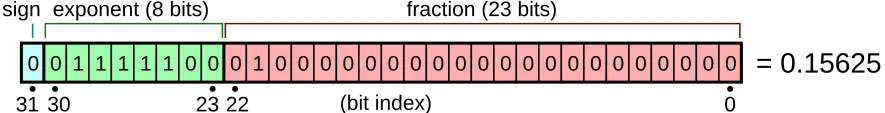

Pesquisadores da BitEnergy AI, Inc. desenvolveram o L-Mul, um método que substitui as multiplicações de ponto flutuante, conhecidas por serem intensivas em energia, por adições inteiras mais simples nas operações computacionais de IA. Para melhor compreensão, a multiplicação de ponto flutuante permite que computadores tratem números de grandes e pequenas magnitudes de forma eficiente, ajustando a posição do ponto decimal, semelhante à notação científica em binário.

O uso de números de ponto flutuante é essencial em muitos cálculos em modelos de IA, mas demanda considerável energia e poder computacional. A relação entre o tamanho dos números utilizados e a eficiência do modelo leva a um aumento do consumo energético proporcional ao crescimento da complexidade computacional.

A Abordagem Proposta pela L-Mul

De acordo com as informações, o L-Mul aborda o problema energético da IA de forma inovadora, ao reimaginar como os modelos de IA realizam cálculos. Em vez de depender de multiplicações complexas de ponto flutuante, o método aproxima essas operações utilizando adições inteiras. Por exemplo, ao invés de multiplicar 123,45 por 67,89, o L-Mul quebra a operação em partes menores, usando adições, resultando em cálculos mais rápidos e que consomem menos energia, mantendo a precisão dos resultados.

“Aplicar a operação L-Mul em hardware de processamento de tensores pode potencialmente reduzir o custo energético em 95% nas multiplicações de tensores de ponto flutuante e em 80% nos produtos escalares.”

Os resultados obtidos com a aplicação do L-Mul são promissores. Isso significa que, se um modelo adotasse essa técnica, haveria uma redução de até 95% no consumo de energia necessário para a execução de tarefas de raciocínio e 80% ao gerar novas ideias.

Resultados e Implicações do L-Mul

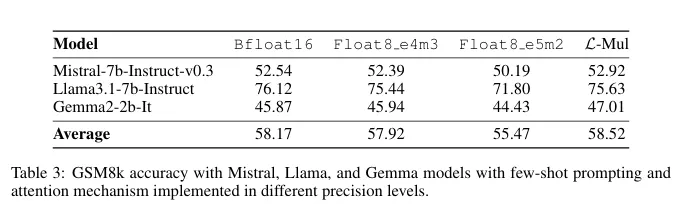

- L-Mul demonstra um desempenho superior em comparação aos padrões atuais de 8 bits, alcançando uma maior precisão enquanto reduz significativamente a computação em nível de bits.

- Testes em tarefas de processamento de linguagem natural, tarefas visuais e raciocínio simbólico mostraram uma média de queda de desempenho de apenas 0,07% — uma troca negligenciável em relação às economias de energia potenciais.

- Modelos baseados em transformadores, que são a espinha dorsal de grandes modelos linguísticos como o GPT, podem se beneficiar enormemente do L-Mul, especialmente na mecânica de atenção, que é uma parte intensiva em cálculos desses modelos.

Eficiência Operacional e a Necessidade de Hardware Especializado

Em termos operacionais, as vantagens do L-Mul são evidentes. A pesquisa indica que multiplicar dois números float8, como atualmente os modelos de IA operam, requer 325 operações, enquanto o L-Mul utiliza apenas 157 operações — menos da metade. “Para resumir a análise de erro e complexidade, o L-Mul é tanto mais eficiente quanto mais preciso do que a multiplicação fp8”, conclui o estudo.

Entretanto, uma limitação significativa dessa técnica é que ela requer um tipo especial de hardware, visto que a tecnologia atual não está otimizada para aproveitar plenamente o L-Mul. Os planos para o desenvolvimento de hardware especializado que suporte nativamente os cálculos L-Mul estão em andamento.

“Para desbloquear todo o potencial do nosso método proposto, implementaremos os algoritmos L-Mul e L-Matmul em nível de hardware e desenvolveremos APIs de programação para o design de modelos de alto nível.”

Esta evolução poderá levar a uma nova geração de modelos de IA que são rápidos, precisos e economicamente viáveis, tornando a IA eficiente em termos energéticos uma possibilidade concreta.

#InteligenciaArtificial, #EficiênciaEnergética, #Tecnologia, #LMul, #Sustentabilidade, #Inovação, #Computação, #ModeloAI

autor original:

Jose Antonio Lanz

ref:https://decrypt.co/285154/new-technique-slashes-ai-energy